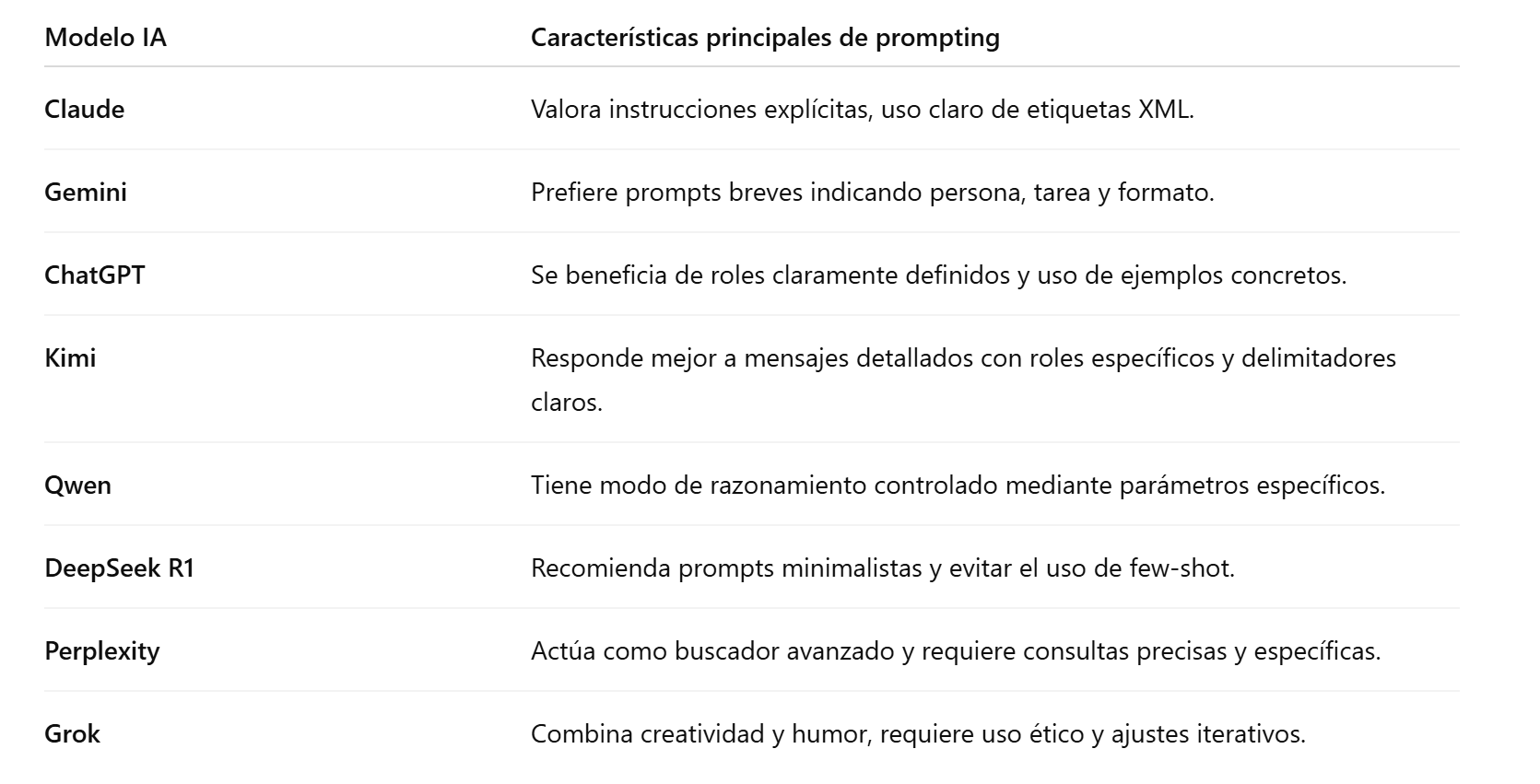

El prompt engineering consiste en dar instrucciones detalladas a los modelos de lenguaje de gran escala. Formular bien los mensajes permite evitar alucinaciones y obtener respuestas orientadas al objetivo. Esta guía combina lo mejor de varias fuentes, incluyendo recomendaciones para GPT‑4 y un libro blanco de prompt engineering, y recoge pautas específicas para modelos como Claude, Gemini, ChatGPT, Kimi, Qwen, DeepSeek R1, Perplexity y Grok. Cada apartado explica cómo estructurar las peticiones, controlar el formato de salida y aprovechar las capacidades de razonamiento de cada plataforma.